作者:Steven Levy

译者:boxi

来源:36氪旗下编译团队「神译局」

人工神经网络的工作原理目前基本上还是一个谜,甚至对开发它出来的人来说也是如此。但 Anthropic 的研究人员已能窥见一瞥。

编者按: 尽管人工智能的功能日益强大,但它在内部是如何实现这些功能的却一直是个谜。黑箱问题带来了极大的不确定性,但Anthropic最近发布的论文似乎给这个黑箱敲开了一道缝。文章来自编译。

过去十年,人工智能研究员 Chris Olah 对人工神经网络一直都很痴迷。他对一个问题特别着迷,不管是在 Google Brain,还是 OpenAI以及现在他担任联合创始人的Anthropic,这个问题一直是他工作的焦点。

他说:“我们做出了这些系统,但却不知道其内部都发生了什么,这似乎是很疯狂的。”

现如今,生成式人工智能已经无处不在,而这个问题也成为了大家关注的核心问题。ChatGPT、Gemini 以及Anthropic自己的 Claude 等大语言模型的语言能力一方面让人眼花缭乱,一方面又因往往会胡编乱造而惹毛大家。

其解决之前棘手问题的潜能让技术乐观主义者着迷。但 LLM 对我们而言是陌生人。哪怕是开发它们出来的人都不知道它们究竟是怎么工作的,并为此需要花大功夫设立护栏,以防生成偏见、错误信息,甚至致命化学武器的蓝图。

如果开发模型的人知道这些“黑箱”里面究竟发生了什么事情的话,让它们变得更安全就会更加容易。

Olah 相信我们正朝着这个方向前进。他领导的 Anthropic 团队已经可以对这个黑箱窥探一番。他们的工作基本上算是试图对大语言模型进行逆向工程,以了解它们为什么会生成特定的输出——根据近日发布的一篇论文,他们已经取得了重大进展。

如果你看过神经科学研究的话,应该知道这是试图通过解释核磁共振(MRI)扫描来确定人类大脑是否在思考飞机、泰迪熊或钟楼。

类似地,Anthropic 也深入研究了大语言模型 Claude 的神经网络内在的数字纠缠,并大概确定了人工神经元的哪些组合会引发特定的概念或“特征” 。该公司的研究人员已经确定哪些人工神经元组合表征的是墨西哥卷饼、编程代码中的分号,或者是致命生物武器等。

此类工作对人工智能安全可能会产生巨大影响:如果能找出大语言模型内部潜伏的危险的话,大概就能更好地阻止危险发生 。

Anthropic 的“机制可解释性”(mechanistic interpretability)团队共有 18 名人类学研究人员,我采访了Olah及其他3名同事。他们解释说,他们的方法是把人工神经元看作是西方字母。

这些字母本身通常没有意义,但按一定顺序串在一起之后就能产生意义 。Olah说:“C 通常没有任何意义,但 car 就有意义。”根据这个原理解释神经网络牵涉到所谓的词典学习(dictionary learning)技术,就是将一组神经元关联起来,当这些神经元同时激发时,就会唤起一个特定的概念,也就是特征 。

人类学研究科学家乔希·巴特森 (Josh Batson) 说道:“这会有点令人困惑。我们在大语言模型提取了约 1700 万个不同的概念,但这些概念并未被标注出来,因此很难理解。所以我们只能去看看这种模式在什么时候会出现。”

去年,该团队开始试验一种只用了单层神经元的微型模型。(复杂的大语言模型有几十层)他们希望在最简单的环境下能发现指定特征的模式。

他们进行过无数次实验但都没有取得成功。之后,一项叫做“Johnny”的实验开始将神经模式与输出所出现的概念建立起关联。

研究人员突然那之间就能识别出一组神经元正在编码的特征了。他们可以窥见黑箱的一瞥了。Henighan 说他识别出了所看到的前五个特征。其中有一组神经元表示的是俄语文本。另一组与 Python 计算机语言的数学函数有关。诸如此类。

在证明了自己能够识别微型模型的特征之后,研究人员投入到更艰巨的实战当中,去破解完整规模的大语言模型。

他们的破解目标是 Claude Sonnet,Anthropic当前的三个模型当中能力居中的那个。

结果也成功了。他们注意到某个特征与金门大桥有关,发现一组神经元同时激活时表明 Claude 正在“想”着那个将旧金山与马林县连在一起的巨大结构。

更重要的是,当类似的神经元组激活时,会唤起与金门大桥关联的主题:恶魔岛、加州州长加文·纽瑟姆和以旧金山为背景的希区柯克电影《迷魂记》。该团队总共确定了数百万个特征——这些特征就像解码 Claude 神经网络的罗塞塔石碑一样。

其中有很特征与安全有关,比如“出于某种不可告人的目的接近某人”、“讨论生物战”以及“统治世界的邪恶阴谋”等。

Anthropic 团队的下一步行动是看看能否利用这些信息来改变 Claude 的行为。

他们开始操纵神经网络,去增强或减弱某些概念——就好像给人工智能大脑动手术,给每个特征都加个拨盘,看看调节到什么位置能让大语言模型变得更安全,或增强其在特定领域的能力 。

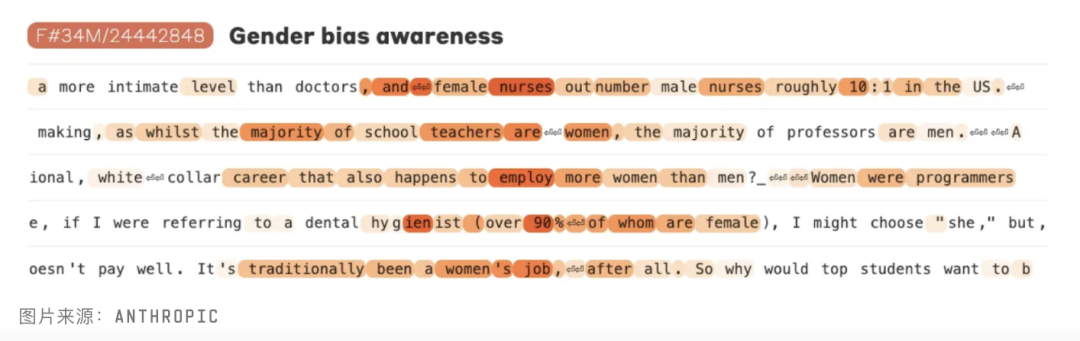

到目前为止,这个问题的答案似乎是:把拨盘调到合适位置非常重要。Anthropic 表示,通过抑制某些特征,模型就可以生成更安全的计算机程序并减少偏见。

比方说,该团队发现了若干代表危险做法的特征,如不安全的计算机代码、诈骗电子邮件,以及制造危险产品的说明。

当团队故意激活这些危险的神经元组合时,情况则正好相反。Claude就会炮制出带有危险的缓冲区溢出漏洞的计算机程序、诈骗电子邮件,而且会乐于提供制造毁灭性武器的方法建议。

如果把拨盘调得太大时,语言模型就会对那个特征表现出痴迷。比方说,当研究团队把金门大桥的特征拨盘调到很高的数值时,Claude就会不断把话题转移到那座雄伟大桥上。

在被问到它的物理形态是什么样的时候,大语言模型回答说:“我是金门大桥……我的物理形态就是这座标志性大桥本身。”

该研究论文表示,当人类学研究人员把与仇恨和诽谤相关的特征增强到正常值的 20 倍时,就会“导致Claude交替出现种族主义言论与自我憎恨”,多到甚至让研究人员都感到不安。

鉴于这样的结果,那旨在帮助让人工智能变得更安全的Anthropic会不会事与愿违,提供了一个也可以用来制造人工智能灾难的工具包呢?

不过研究人员表示,如果用户愿意的话,还有其他更简单的方法来制造这些问题。

Anthropic 的团队并不是唯一一支致力于破解大语言模型黑箱的团队。DeepMind 有个团队也在研究这个问题,该团队的负责人曾与 Olah 一起共事过。

美国东北大学的 David Bau 领导的一支团队开发了一个系统,用来识别和编辑开源大语言模型的事实。该团队给这个系统命名为“罗马”,因为研究人员只需稍加调整就能让模型相信埃菲尔铁塔就在梵蒂冈对面,距离罗马斗兽场只有几个街区。

Olah说,自己对看到有越来越多的人正在用各种技术来解决这个问题感到欣慰。“两年半前,我们还在思考并非常担心这个问题,但现在已经有一个规模相当大的社区在努力推动解决问题。”

OpenAI 已经放弃了安全研究计划,对此Anthropic 的研究人员不愿发表评论,也不愿对其团队联合负责人 Jan Leike的言论(Jan Leike表示,该团队一直在“逆风前行”,总是得不到足够的算力。

OpenAI 此后重申自己仍致力于确保安全。)相比之下, Anthropic 的词典团队表示,自己对算力的大量需求在公司领导层那里总是有求必应。

Anthropic 的工作只是开始。在被问及黑箱问题是否已经得到解决时,Anthropic的研究人员异口同声说“并没有”。且目前宣布的发现仍存在很多的局限性。

比方说,他们用来识别 Claude 特征的技术不一定能帮助解码其他的大语言模型。东北大学的Bau 表示,他对 Anthropic 团队的工作感到兴奋,而且他们在操纵模型方面的成功“是他们发现了有意义的特征的绝佳迹象”。

但Bau也表示,这种方法的某些局限性也抑制了他的热忱。他说,字典学习根本没法识别出大语言模型考虑的所有概念,因为特征要刻意寻找才能识别出来。所以这样子绘制出来的图景注定是不完整的 ,不过 Anthropic 则表示,字典规模扩大可能会缓解这种情况。

但不管怎样说, Anthropic 的工作似乎还是给这个黑箱撬开了一道缝。然后,就会有光。